Contenido del post

El trabajo realizado en el SEO de una web es una parte clave para que la misma tenga éxito, puesto que le da una visibilidad increíble y puedes llegar a alcanzar una gran cantidad de tráfico en tu web.

Para mejorar el SEO, existen mil maneras, tácticas y herramientas que te ayudan a posicionar tu web en los buscadores. Una de las cosas que puedes hacer para mejorar el SEO de tu página es crear e implementar el archivo robots.txt. Si no tienes ni idea de que es este archivo o estás buscando como implementarlo, has llegado al sitio correcto.

¿Qué es el archivo robots.txt?

El archivo robots.txt es un simple archivo de texto (de ahí el .txt) que sirve para dar instrucciones para los robots usados por los motores de búsqueda como Google o Bing, indicando que páginas pueden rastrear y cuáles no.

Esto es muy útil para evitar que los motores de búsqueda no rastreen páginas innecesarias (por ejemplo, la política de privacidad de tu web) y no pierdan tiempo en ellas, ya que los motores de búsqueda asignan un número de páginas limitado para cada web y otras páginas que sí nos importan podrían quedar fuera.

¿Cuál es el funcionamiento del archivo robots.txt?

Una vez que ya sabes lo que es el archivo robots.txt, vamos a ver de una manera simple como funciona.

En primer lugar, los robots de los motores de búsqueda rastrean tu web siguiendo las directrices que les has dado en el archivo de texto. Acto seguido, indexan el contenido rastreado para mostrarlo en los resultados de búsqueda.

Esto es de manera muy resumida lo que hacen estos robots, saltando de enlace en enlace a través de los millones de páginas que hay en la web.

¿Cómo crear el archivo robots.txt?

Vamos a lo importante, ¿Cómo creo un archivo robots.txt para mi web?

Antes de explicarte como crearlo, te doy la opción de sitios y herramientas por si no quieres calentarte la cabeza y hacerlo de manera automática. Si tu sitio web está creado en WordPress, existen plugins como Rank Math que te crean un archivo robots.txt y lo suben de manera automática a tu web. También dispones de páginas web como SEOptimer, que ofrecen un creador de sitemaps donde tú pones los datos de tu web y ellos se encargan del resto.

Si quieres aprender un poco más acerca de este archivo, vamos a ver paso a paso como crear uno personalizado para nuestra web.

1. Crear archivo .txt

Vamos a abrir un nuevo documento en nuestro bloc de notas del ordenador y nómbralo como ‘robots.txt’ para que funcione. Una vez creado, ya podemos empezar a escribir en él mediante las llamadas reglas.

Las reglas son las instrucciones que indicamos a los motores de búsqueda para que sepan que partes de nuestra web deben rastrear. Aquí tienes el listado de reglas que admite Google y los principales motores de búsqueda:

- User-agent: es siempre la primera línea e indica a que bot va dirigida la regla. Si ponemos un ‘*’, se aplicará a todo el conjunto de bots.

- Disallow/Allow: en cada regla debe haber al menos uno de estos dos. Disallow indica una página del dominio de tu web que no quieres que rastree el bot que has indicado en el user-agent. Allow sirve para anular la regla Disallow y permitir que el bot rastree una determinada subpágina de la página bloqueada.

- Sitemap: es opcional, pero muy recomendable su uso. Sirve para indicar donde está ubicado el sitemap o mapa del sitio de nuestra web.

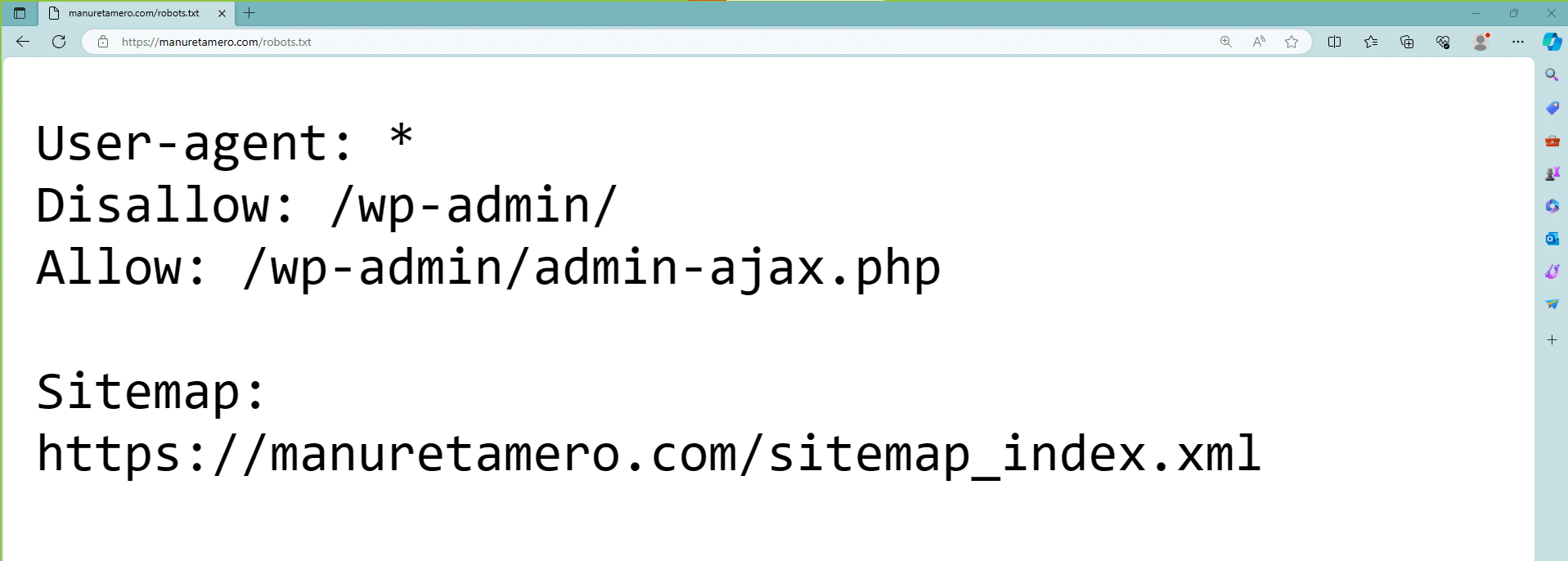

Con esto, ya puedes crear el archivo robots.txt de tu web. Deberías tener algo así:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://manuretamero.com/sitemap_index.xml

Este es el robots.txt de esta web, uno bastante simple y en el cuál solo estamos bloqueando a los bots el paso al directorio ‘wp-admin’ de nuestra web, ya que es donde está la información de WordPress y no queremos que el usuario vea este contenido. También le hemos indicado el sitemap de mi web.

Ahora que ya sabes cómo se crea el archivo, tú decides que sitios quieres que se vean o no de tu web y que bots no quieres dejar pasar. Te dejo un listado de los rastreadores de Google para que puedas probar y ver sus funciones.

2. Subir archivo robots.txt

Una vez tengas creado y guardado tu archivo robots.txt, es el momento de subirlo a tu web. Siento decirte que no existe un método universal o una herramienta como para crear el archivo, sino que depende de la estructura de archivos de tu web y del alojamiento.

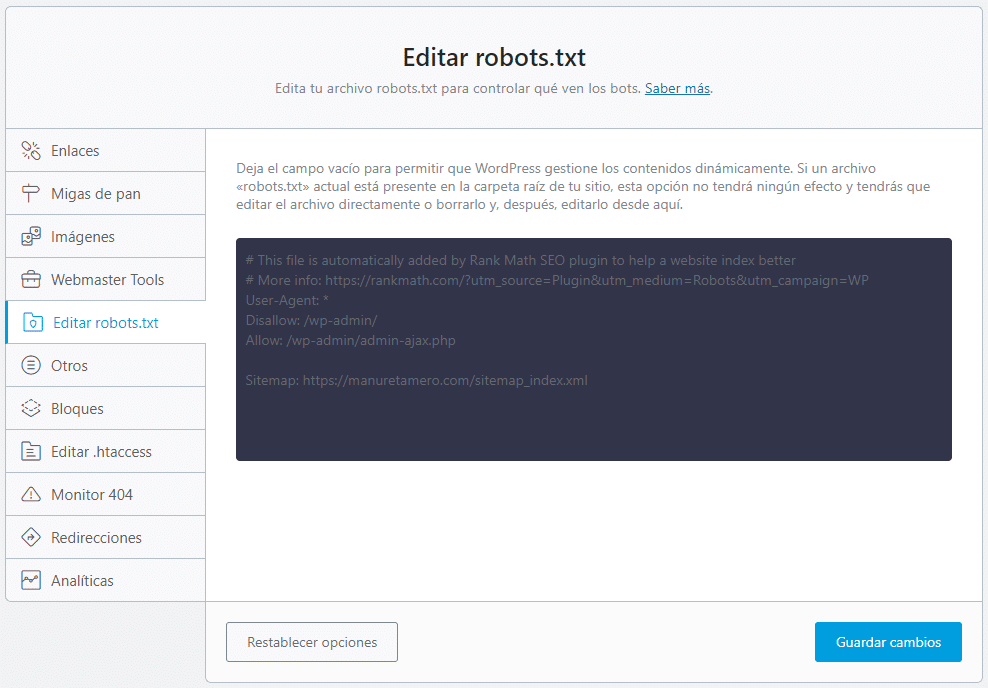

Si tu web está hecha con WordPress, puedes usar el plugin mencionado anteriormente llamado Rank Math, aquí te dejo una guía.

3. Comprobar que el robots.txt está correcto

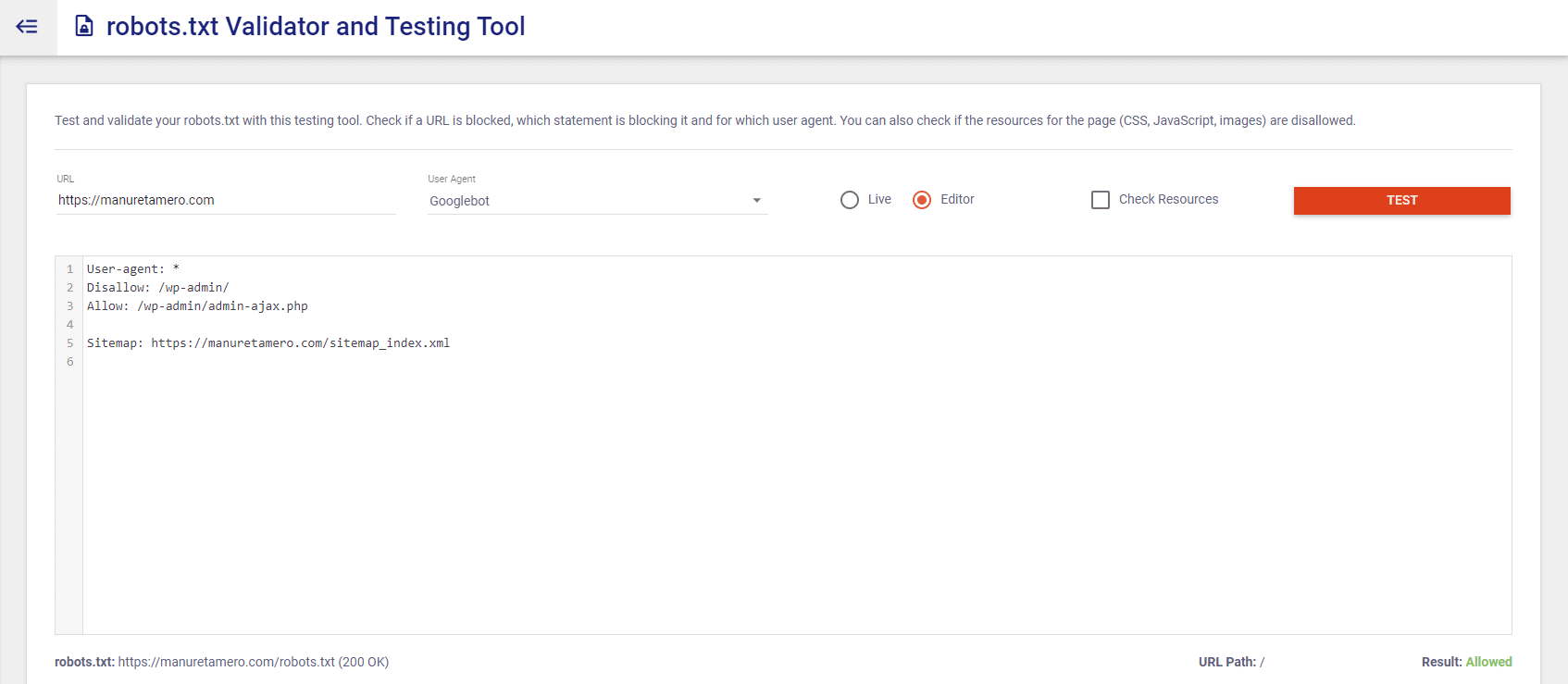

Para comprobar el robots.txt de tu web, tan sólo tienes que usar tu cuenta Google Search Console y abrir el ‘comprobador de tobots.txt’, una herramienta de la propia Google que te indicará si el archivo subido es válido e incluso te marcará si hay algún error. Además, puedes editarlo y arreglarlo desde la misma herramienta.

Si no tienes conectado tu dominio a GSC (cosa que te recomiendo que hagas), existen paginas como Merkle, que cuenta con un validador del archivo para comprobar su estado.

Por último, también puedes mirar tu archivo y el de cualquier web de forma manual, introduciendo su dominio raíz seguido de /robots.txt. Por ejemplo, aquí tienes el robots txt de Google: https://www.google.com/robots.txt.

Con esta información, ya deberías estar más que preparado para poder crear tu propio robots.txt y entender el funcionamiento del mismo. Esto que acabamos de hacer es un paso clave para el SEO de nuestra web, si bien aún queda mucho trabajo por hacer.

Si quieres seguir mejorando el posicionamiento de tu web y tu estrategia de marketing digital, echa un vistazo a otros artículos de mi blog. Para que sigas mejorando el SEO, te dejo una pequeña guía para el SEO Local de tu empresa. ¡Te espero!